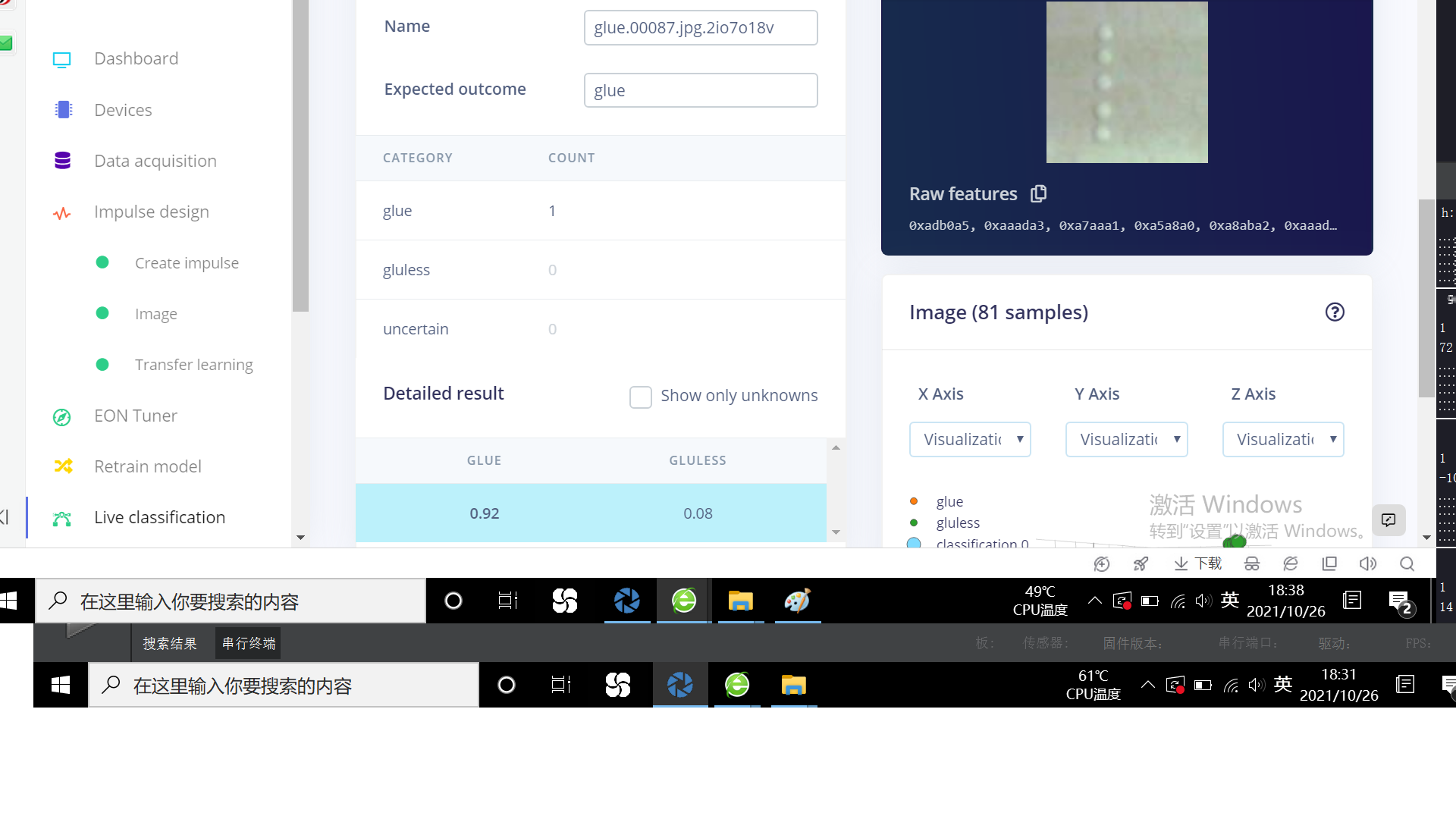

续之前edge impulse 训练结果与实际在线不一致问题的改进,效果不好。

-

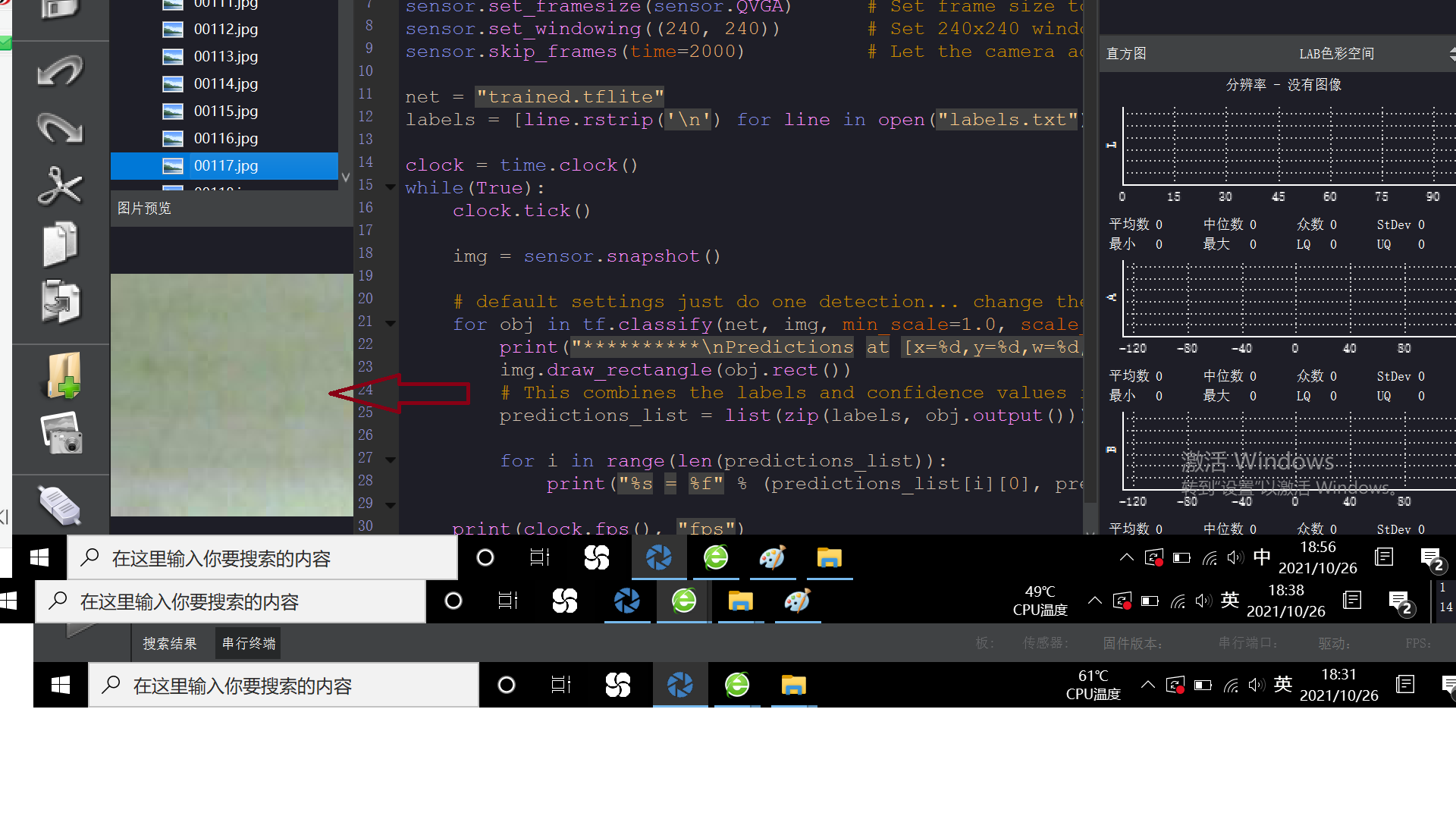

感谢您之前的回复,按照您的建议,有变化的部分在图像中占比不宜太小,故做了调整,采集时候的代码:

原来的:sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.QVGA)改为了:sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.VGA)

sensor.set_windowing((100,100))

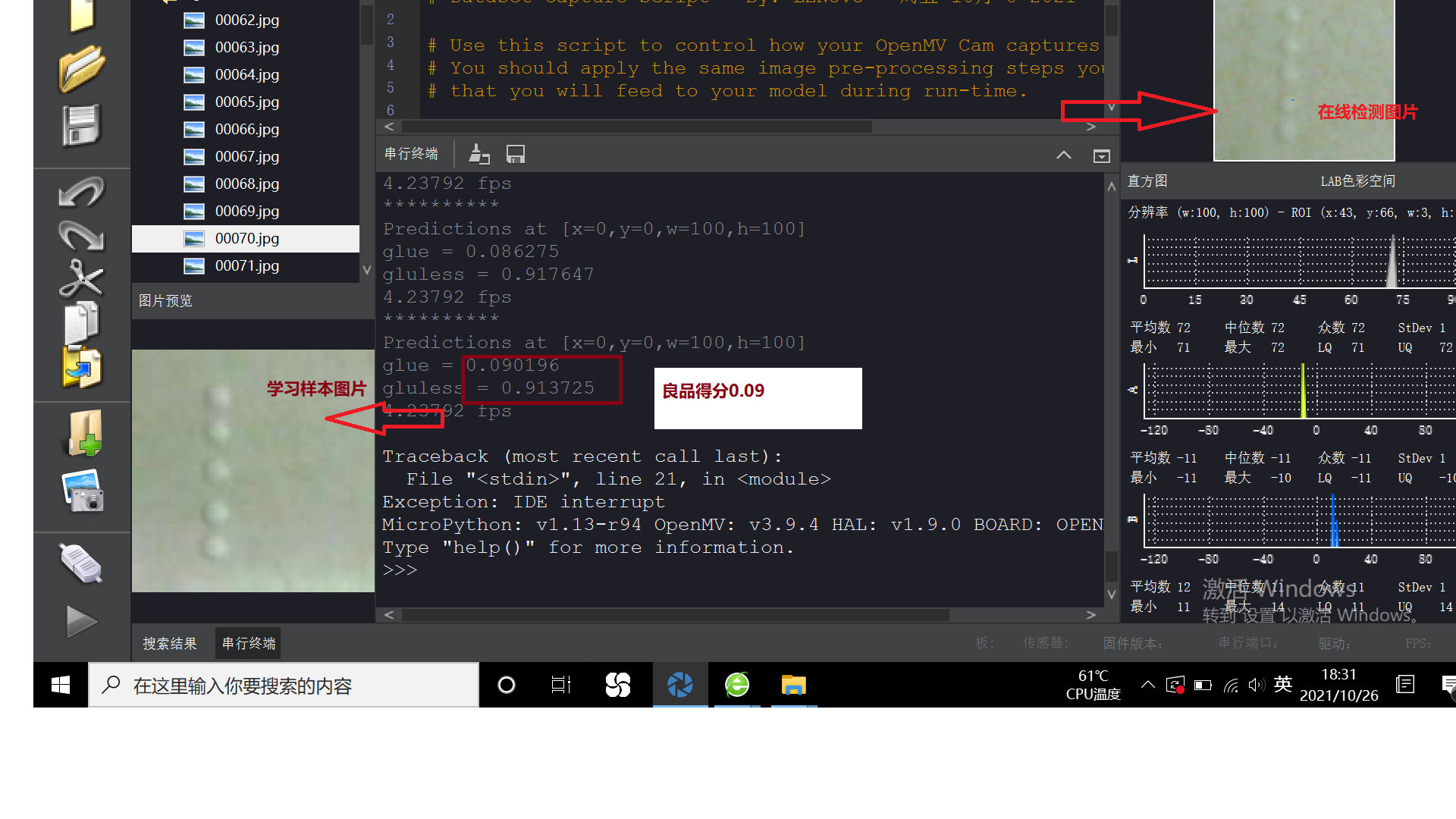

这样一来,有无胶在视野中变化很大,但是依然不行,请看

是不是不能改dataset_capture_py里面的代码?

为什么dataset_capture_py里默认是QVGA

但是edge impulse生成的ei_classification里就自动变成了QVGA的(240,240)?

-

你的数据集的数量是多少?无胶的照片是什么?

-

神经网络会自动缩放图片然后分类,所以QVGA是没问题的。

-

无胶照片这样的。您的意思是不是ei里面的分辨率最好不要改??

-

看上去区别很明显的。

先来一个边缘滤波。

https://book.openmv.cc/example/04-Image-Filters/edge-filter.html然后用统计信息,应该可以直接分类出来了,(不用神经网络),就是边缘的像素的数量大于多少来判断。

如果要用神经网络也可以,要不同角度,不同位置,不同数量的采集多张。

另外,如果能靠灯光,来让胶更明显,是非常有用的。

-

举个例子,如果光从侧面照过来,就会出现非常明显的阴影,就可以把有胶和无胶分清。

-

谢谢,光源我早已买好红色、绿色,马上开始推进实验